웹 크롤링(웹 데이터 추출 또는 웹 스크래핑)은 오늘날 많은 분야에서 광범위하게 적용되고 있는 기술입니다. 웹 크롤링이 보편화된 기술은 아니라서 생소한 사람들이 꽤 많을 겁니다. 하지만 오늘 소개해 드릴 20가지 웹 크롤러 제품은 코딩을 잘 몰라도 입문하기 좋은 도구입니다.

이 블로그에서는 데스크톱 디바이스, 브라우저 플러그인 또는 기타 클라우드 서비스를 기반으로 상위 20개 웹 크롤러를 소개해 드리겠습니다. 무료와 유료, 클라우드와 로컬 환경 모두 포함되어 있으니, 업무에 가장 적합한 도구를 선택해 주시면 됩니다.

웹 크롤링 도구가 필요한 이유

웹 크롤러는 다음과 같은 상황에서 도움이 될 수 있습니다:

- 복사 및 붙여넣기와 같은 반복 작업 대체안

- Excel, HTML 및 CSV에 국한되지 않는 정리된 데이터 수집 가능

- 시간, 인력 및 비용 절약

- 마케팅 담당자, 온라인 도소매업자, 언론인, 유튜버, 연구원 및 기타 코딩 기초가 없는 사람들을 위한 데이터 수집 방안

써보면 절대 후회 안 하는 20가지 웹 크롤링 도구

1. Octoparse

Octoparse는 윈도우와 macOS 시스템을 기반으로 웹 데이터를 스프레드시트로 쉽게 가져올 수 있는 웹 크롤링 도구입니다. 사용자 친화적인 인터페이스를 갖춘 소프트웨어는 코딩 초보분들도 쉽게 입문할 수 있도록 특별히 설계 제작되었습니다. Octoparse에 대한 소개는 다음 유튜브 동영상을 통해 만나보세요.

Octoparse 웹 크롤러의 주요 기능:

- 클라우드 추출 일정 예약: 동적 데이터를 실시간으로 추출합니다.

- 자동 인식 모드: 웹 페이지 데이터를 자동으로 스크랩합니다.

- 바로 쓸 수 있는 템플릿: 몇 번의 클릭으로 인기 웹사이트의 데이터를 쉽게 크롤링할 수 있습니다.

- 캡차 차단 우회: ReCaptcha 및 차단을 우회하기 위한 클라우드 서비스 및 IP 프록시 서버.

- 데이터 클리닝: Regex 및 XPath 내장 도구로 데이터를 자동으로 정제합니다.

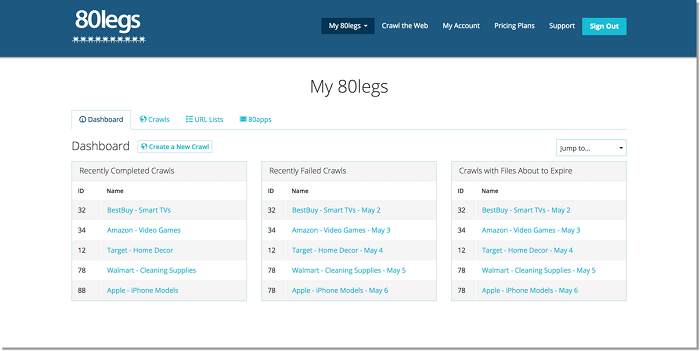

2. 80 legs

80 legs는 사용자 요구 사항을 기반으로 커스터마이징할 수 있는 강력한 웹 크롤링 도구입니다. 추출된 데이터를 즉시 다운로드할 수 있는 옵션으로 엄청난 양의 데이터를 가져올 수 있도록 지원합니다.

80개 다리의 주요 기능:

- API: 80legs는 사용자가 크롤러를 만들고 데이터를 관리하는 등의 API를 제공합니다.

- 스크래퍼 커스터마이징: 80legs의 JS 기반 앱 프레임워크를 통해 사용자는 맞춤형 웹 크롤러를 구성할 수 있습니다.

- IP 서버: IP 주소 풀은 웹 스크래핑 요청에 사용됩니다.

3. ParseHub

Parsehub는 AJAX 기술, 자바스크립트, 쿠키 등을 사용하여 웹사이트에서 데이터를 수집하는 웹 크롤러입니다. 머신 러닝 기술로 웹 문서를 읽고 분석한 다음 관련 데이터로 변환할 수 있습니다.

Parsehub 주요 기능:

- 통합: Google Sheets, Tableau

- 데이터 포맷 : JSON, CSV

- 디바이스: Mac, Windows, Linux

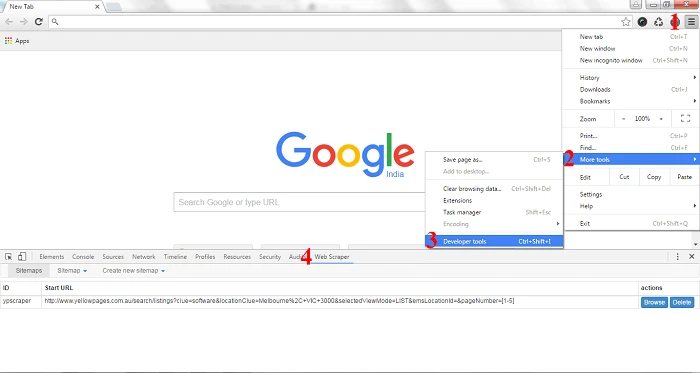

4. Visual Scraper

VisualScraper는 SaaS 외에도 데이터 전달 서비스, 맞춤형 추출 도구 제작 등의 웹 스크래핑 서비스를 제공합니다. Visual Scraper를 사용하면 프로젝트가 특정 시간에 실행되도록 예약하거나 분, 일, 주, 월 또는 연 단위로 작업 실행을 반복할 수 있습니다. 사용자는 이를 사용하여 뉴스, 업데이트 및 포럼을 유용하게 추출할 수 있습니다.

Visual Scraper 주요 기능:

- 다양한 데이터 형식: Excel, CSV, MS Access, MySQL, MSSQL, XML 또는 JSON.

- 공식 웹사이트 업데이트가 더디고 최신 정보 업데이트 속도가 느립니다.

5. WebHarvy

WebHarvy는 포인트 앤 클릭 방식의 웹 스크래핑 소프트웨어입니다. 프로그래머가 아닌 초보자를 대상으로 설계되었습니다.

WebHarvy 주요 기능:

- 웹 사이트에서 텍스트, 이미지, URL 및 이메일을 수집합니다.

- 프록시 지원으로 익명 크롤링이 가능하며 웹 서버에 의해 차단되는 것을 방지합니다.

- 데이터 형식: XML, CSV, JSON 또는 TSV 파일. 스크랩된 데이터를 SQL 데이터베이스로 내보낼 수도 있습니다.

6. Sequentum

Content Grabber(현재 Sequentum)는 기업을 대상으로 하는 웹 크롤링 소프트웨어입니다. 독립형 웹 크롤링 에이전트를 만들 수 있을 뿐만 아니라 사용자가 C# 또는 VB를 사용할 수 있습니다. NET는 크롤링 프로세스 프로그래밍을 제어하기 위해 디버깅하거나 스크립트를 작성합니다. 거의 모든 웹 사이트에서 콘텐츠를 추출하여 원하는 형식의 구조화된 데이터로 저장할 수 있습니다.

Content Grabber 주요 기능:

- 제3자 데이터 분석 또는 보고 애플리케이션과의 통합.

- 강력한 스크립팅 편집 및 디버깅 인터페이스.

- 데이터 포맷: Excel 보고서, XML, CSV 및 데이터베이스.

7. Helium Scraper

헬륨 스크레이퍼는 사용자가 웹 데이터를 크롤링할 수 있는 시각화 웹 데이터 크롤링 소프트웨어입니다. 신규 사용자 대상으로 10일 무료 체험을 제공하며 일회성 구매로 영구적으로 소프트웨어를 사용할 수 있습니다. 사용자의 기본적인 크롤링 요구를 충족시킬 수 있습니다.

헬륨 스크래퍼 주요 기능:

- 데이터 형식: CSV, Excel, XML, JSON 또는 SQLite 형식으로 데이터를 내보냅니다.

- 빠른 추출: 이미지 또는 원하지 않는 웹 요청을 차단하는 옵션을 제공합니다.

- 프록시 전환.

웹 사이트 다운로더:

8. Cyotek WebCopy

Cyotek WebCopy는 오프라인 참조를 위해 부분 또는 전체 웹 사이트를 하드 디스크에 로컬로 복사할 수 있는 무료 웹 사이트 크롤러입니다. 설정을 변경하여 봇에게 크롤링하고 싶은 방법을 명령할 수 있습니다. 이 외에도 도메인 별칭, 사용자 에이전트 문자열, 기본 문서 등을 구성할 수도 있습니다.

그러나 WebCopy에는 가상 DOM 또는 자바스크립트 구문 분석 형식이 포함되어 있지 않습니다. 웹 사이트가 운영하기 위해 자바스크립트를 많이 사용하는 경우 WebCopy가 실제 복사본을 만들지 못할 가능성이 더 높습니다. 자바스크립트를 많이 사용하기 때문에 동적 웹 사이트 레이아웃을 올바르게 처리하지 못할 우려가 있습니다.

9. HTTrack

웹 사이트 크롤러 프리웨어로서 HTtrack은 전체 웹사이트를 PC에 다운로드하기에 매우 적합한 기능을 제공합니다. Windows, Linux, Sun Solaris 및 대부분의 사용자를 대상으로 하는 기타 Unix 시스템용 버전이 있습니다. HTtrack이 하나의 사이트 또는 둘 이상의 사이트(공유 링크 포함)를 함께 미러링할 수 있다는 점은 흥미롭습니다. “설정 옵션”에서 웹 페이지를 다운로드하는 동안 동시에 오픈할 수 있는 연결 수를 결정할 수 있습니다. 미러링 된 웹사이트에서 사진, 파일 및 HTML 코드를 가져와 중단된 다운로드를 재개할 수 있습니다.

또한 속도를 극대화하기 위해 HTtrack 내에서 프록시 지원을 사용할 수 있습니다. HTtrack은 command-line 프로그램으로 작동하거나 개인(캡처) 또는 전문가(온라인 웹 미러) 사용을 위해 shell을 통해 작동합니다. 따라서 HTtrack은 기본 프로그래밍 기술을 갖춘 사람들이 더 선호하는 제품입니다.

10. Getleft

Getleft는 14개국 언어 지원이 되는 무료로 사용하기 쉬운 웹 사이트 크롤러입니다. 전체 웹 사이트 또는 단일 웹 페이지를 다운로드할 수 있습니다. Getleft를 시작한 후 URL을 입력하고 다운로드할 파일을 선택한 후 작업을 시작할 수 있습니다. 그러나 제한된 Ftp 지원만 제공하며 파일 다운로드를 지원하긴 하지만 반복으로 일정에 맞춰 다운로드하지는 않습니다.

웹 크롤러 플러그인:

11. Scraper

Scraper는 데이터 추출 기능이 제한된 Chrome 플러그인입니다. 또한 Google 스프레드시트로 데이터를 내보낼 수 있습니다. 초보자나 전문가 모두 사용할 수 있는 이 도구는 데이터를 클립보드에 쉽게 복사하거나 OAuth를 사용하여 스프레드시트에 저장할 수도 있습니다. Scraper는 크롤링할 URL을 정의하기 위한 XPath를 자동으로 생성할 수 있습니다. 일반적인 크롤링 서비스를 제공하지는 않지만 제법 구성이 간단한 스크래퍼입니다.

12. OutWit Hub

OutWit Hub는 웹 검색을 단순화하기 위해 수십 가지 데이터 추출 기능을 갖춘 Firefox 추가 기능입니다. 이 웹 크롤러 도구는 페이지를 훑어보고 추출된 정보를 적절한 형식으로 저장할 수 있습니다.

OutWit Hub는 필요에 따라 아주 작거나 방대한 양의 데이터를 스크랩할 수 있는 단일 인터페이스를 제공합니다. OutWit Hub를 사용하면 브라우저 자체에서 모든 웹 페이지를 가져올 수 있습니다. 자동 에이전트를 생성하여 데이터를 추출할 수도 있습니다.

가장 간단한 웹 스크래핑 도구 중 하나로 코딩 입력 없이 자유롭게 웹 데이터를 추출할 수 있는 편리함을 제공합니다.

웹 스크래핑 서비스:

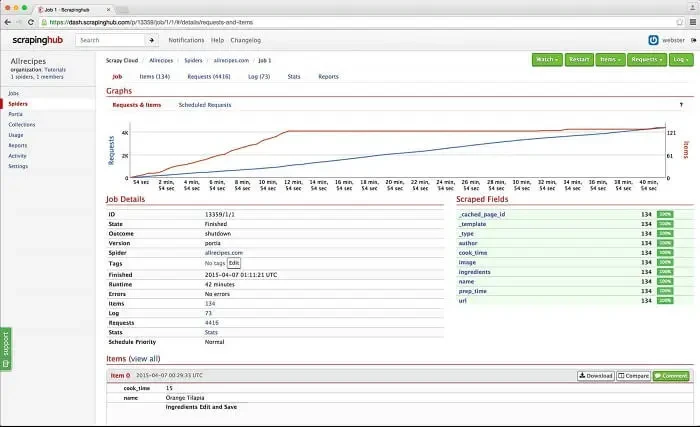

13. Zyte

Zyte(旧 Scrapinghub)는 클라우드 기반 데이터 추출 도구로 수천 명의 개발자가 데이터를 가져올 수 있도록 지원합니다. 오픈 소스 시각화 스크래핑 도구를 사용하면 프로그래밍 기초 지식 없이 웹사이트를 쉽게 스크래핑할 수 있습니다.

Zyte는 스마트 프록시 전환 툴 Crawlera를 사용하여 크롤러 로봇 방지 조치를 우회하는 강력한 도구입니다. 간단한 HTTP API를 통해 프록시 관리 업무의 고통 없이 여러 IP와 주소로 효과적으로 크롤링할 수 있습니다.

Zyte는 전체 웹 페이지를 정리된 콘텐츠로 변환합니다.

14. Dexi.io

브라우저 기반 웹 크롤러인 Dexi.io 를 사용하면 웹 사이트에서 브라우저를 기반으로 데이터를 스크래핑 작업을 생성할 수 있는 세 가지 유형의 로봇(추출기, 크롤러 및 파이프)을 제공할 수 있습니다. 프리웨어는 웹 스크래핑을 위한 익명의 웹 프록시 서버를 제공하며, 추출된 데이터는 데이터가 보관되기 전 2주 동안 Dexi.io의 서버에 호스팅 되거나, 추출된 데이터를 JSON 또는 CSV 파일로 직접 내보낼 수 있습니다. 실시간 데이터 추출을 위한 유료 서비스도 제공합니다.

15. Webhose.io

Webhose.io 를 사용하면 전 세계의 온라인 소스를 다양하고 정리된 형식으로 크롤링하여 실시간 데이터를 얻을 수 있습니다. 이 웹 크롤러를 사용하면 데이터를 크롤링하고 광범위한 소스를 포함하는 여러 필터를 사용하여 다양한 언어로 키워드를 추가로 추출할 수 있습니다.

그리고 스크랩된 데이터를 XML, JSON 및 RSS 형식으로 저장할 수 있습니다. 그리고 사용자는 아카이브에서 히스토리 데이터에 액세스할 수 있습니다. 또한 webhose.io는 크롤링 데이터 결과와 함께 최대 80개 언어를 지원합니다. 사용자는 Webhose.io에서 크롤링한 구조화된 데이터를 쉽게 인덱싱하고 검색할 수 있습니다.

전반적으로 Webhose.io는 사용자의 기본적인 크롤링 요구 사항을 충족시킬 수 있습니다.

16. Import. io

사용자는 특정 웹 페이지에서 데이터를 가져와 CSV로 내보내기만 하면 자신만의 데이터셋을 구성할 수 있습니다.

코드 한 줄 작성 없이 수천 개의 웹 페이지를 몇 분 만에 쉽게 스크래피하고 요구 사항에 따라 1,000개 이상의 API를 구축할 수 있습니다. 공용 API는 Import.io를 프로그래밍 방식으로 제어하고 데이터에 자동으로 액세스할 수 있는 강력하고 유연한 기능을 제공하며, Import.io는 몇 번의 클릭만으로 웹 데이터를 자신의 앱 또는 웹 사이트에 통합함으로써 크롤링을 더 쉽게 만들 수 있습니다.

또한 사용자의 크롤링 요구 사항을 더 잘 충족시키기 위해 Windows, Mac OS X 및 Linux에서 데이터 추출기 및 크롤러를 구축하고 데이터를 다운로드하고 온라인 계정과 동기화할 수 있는 무료 앱을 제공합니다. 또한 사용자는 매주, 매일 또는 시간당 크롤링 작업을 예약할 수 있습니다.

17. Spinn3r

Spinn3r을 사용하면 블로그, 뉴스 및 소셜 미디어 사이트, RSS 및 ATOM 피드에서 전체 데이터를 가져올 수 있습니다. Spinn3r은 인덱싱 작업의 95%를 관리하는 Firehouse API와 함께 배포됩니다. 고급 스팸 보호 기능을 제공하여 스팸 및 부적절한 언어 사용을 제거하여 데이터 안전성을 향상합니다.

Spinn3r은 Google과 유사하게 콘텐츠를 인덱싱하고 추출된 데이터를 JSON 파일에 저장합니다. 웹 스크래퍼는 웹을 지속해서 검색하고 여러 출처의 업데이트를 찾아 실시간 발표물을 가져옵니다. 관리자 콘솔을 통해 크롤링을 통제할 수 있으며 전체 텍스트 검색을 통해 원시 데이터에 대한 복잡한 쿼리를 만들 수 있습니다.

웹 스크래핑 RPA 도구

18. UiPath

UiPath는 무료 웹 스크래핑을 위한 로봇 프로세스 자동화 소프트웨어입니다. Uipath는 여러 웹 페이지에서 테이블 형식 및 패턴 있는 데이터를 추출할 수 있습니다.

Uipath는 추가 크롤링을 위한 내장 도구를 제공합니다. 이 방법은 복잡한 UI를 다룰 때 매우 효과적입니다. 스크린 스크래핑 툴은 테이블 형식의 데이터 추출과 같이 개별 텍스트 요소, 텍스트 그룹 및 텍스트 블록을 모두 처리할 수 있습니다.

지능형 웹 에이전트를 만드는 데 별도의 프로그래밍 없이 내부의 NET 해커로 데이터를 완벽하게 통제할 수 있습니다.

프로그래머를 위한 라이브러리

19. Scrapy

Scrapy는 Python에서 실행되는 오픈 소스 프레임워크입니다. 라이브러리는 프로그래머가 웹 크롤러를 커스텀하고 웹에서 대규모로 데이터를 추출할 수 있는 즉시 사용할 수 있는 구조를 제공합니다. Scrapy를 사용하면 어떤 데이터를 추출하고, 어떤 방식으로 데이터를 정제하고, 어떤 형식으로 내보낼지 등을 정확히 정의할 수 있습니다.

20. Puppeteer

Puppeteer는 구글이 개발한 노드 라이브러리입니다. 프로그래머가 DevTools 프로토콜을 통해 Chrome 또는 Chrome을 제어할 수 있도록 API를 제공하며, 프로그래머가 Puppeteer 및 Node.js로 웹 스크래핑 도구를 구축할 수 있도록 지원합니다. 프로그래밍을 처음 시작하는 사람이라면 튜토리얼을 숙지하는 데 시간을 많이 걸릴 수 있습니다.

Puppeteer는 웹 스크래핑 외에도 다음과 같은 용도로 사용됩니다.

- 웹 페이지의 스크린샷 또는 PDF를 가져올 때

- 양식 제출/데이터 입력을 자동화할 때

- 자동 테스트를 위한 도구를 만들 때

마무리

이제 20개의 다양한 웹 크롤러에서 가장 적합한 크롤러를 선택하시면 됩니다. 코딩에 대한 기초가 없다거나 웹 크롤링에 대한 시간과 비용을 절약하고 싶다면 Octoparse가 최선의 선택입니다. 이 블로그가 웹 크롤러 솔루션을 찾는데 도움이 되셨길 바랍니다.